ChatGPT-4oとは何? 何ができる? 使い方や料金形態を徹底解説

2022年末にChatGPTがリリースされて以降、まるで人間のような働きをみせる生成AIへの注目度が高まっています。その開発元であるOpenAI以外にも、GoogleやMicrosoftといったIT業界で圧倒的な影響力を持つ企業が軒並み生成AIの開発に力を入れ、性能の改善や新技術の開発を進めています。そうしたなかで、2024年5月に「GPT-4o」がリリースされました。GPTシリーズにおける当時の最新モデルとして、従来型をはるかにしのぐ性能を誇り、生成AIの活用の幅がさらに広がることに期待が寄せられています。

ChatGPT-4oとは何か

ChatGPT-4o(Omni:オムニ)とは、OpenAIが2024年5月に発表したChatGPTのモデルです。「オムニ」とはラテン語で「すべて」という意味を持ち、従来のテキストや画像に加えて音声までも統合的に処理できる「マルチモーダルAI」として、より一層の進化を遂げました。

一つ前のモデルであるChatGPT-4 Turboと比べて、回答の精度とスピードが圧倒的に向上したことに加え、人間の目と同様の細かな画像認識能力や、リアルタイムでの感情豊かな音声会話能力など、多方面での高性能化が進められています。

なお、ChatGPT-4oは、ChatGPTの有料プランだけでなく、無料版でも利用することが可能です。無料版で利用する際には、回数や機能に一定の制限があることに注意が必要です。

GPT-4o miniについて

GPT-4o miniは、OpenAIが2024年7月に発表した自然言語処理モデルです。GPT-4oの機能を引き継ぎながら、より軽量かつ安価に利用できる点で優れています。ただし、GPT-4oより出力スピードが高まった一方で、推論などの複雑なタスクを実施する場合には、やや精度が劣る可能性があるとされます。

GPT-4o miniが注目を集めた主な理由に、SLM(小規模言語モデル)であることが挙げられます。大量のデータセットと深層学習を用いるLLM(大規模言語モデル)とは異なり、SLMはパラメータ数を少なくして必要な部分にのみリソースを集中させることで、高速かつ高精度な出力を可能としています。そのため、GPT-4o miniは小規模なデバイスやクラウド上での利用も可能です。

また、新しいデータを学習させて特定のタスクや用途に合わせた最適化を行う「ファインチューニング」の機能も解放されており、さまざまなシーンでの活用が期待されています。

ChatGPT-4oにおける最新のアップデート情報

ChatGPT-4oにみられる数々のアップデートは、AIを取り巻く技術の進展において重要な意味を持っています。ChatGPT-4oの詳細な特徴に関しては後述しますが、ここでは特に注目すべきポイントを3つご紹介します。

まず1つ目は「応答時間の向上」です。音声認識機能に関して、GPT-4では平均5.4秒の待ち時間がありましたが、GPT-4oでは平均0.320秒、最短で0.232秒の応答時間を実現しています。このスピードは人間との会話と同程度の水準です。

2つ目が「英語以外の言語能力の向上」です。ChatGPTは元々、英語をベースにしたデータを用いて開発されてきたため、従来のモデルでは英語以外の出力精度に弱みがありました。今回、日本語をはじめとする英語以外の言語も用いて訓練されたため、処理は効率化され、返答の精度が大幅に向上しています。

そして3つ目が「マルチモーダル化の発展」です。従来のGPT-4モデルはテキストのほかに、画像も理解できるマルチモーダルモデル(複数の異なる種類のデータを統合して処理可能なモデル)でしたが、GPT-4oでは、それらに加えて音声も組み合わせた入力と出力が可能になりました。これにより、文脈に即した言語処理だけでなく、話し手の感情を加味するなど、人間同士のやりとりに近い、より複雑な対話ができます。

ChatGPT-4oの料金形態

ChatGPT-4oは、個人向けのChatGPT Plusをはじめとする各有料プランで利用できます。無料版でも利用自体は可能ですが、あくまでも日常で簡単に試す場合を想定したプランであるため、1日に使用できる回数などに一定の制限がある点に注意が必要です。

APIも含めた、各プランの料金形態は以下の通りです。

| プラン | 料金 | 対象イメージ |

|---|---|---|

| ChatGPT(無料版) | 無料 | 日常で試してみたい個人 |

| ChatGPT Plus | 月額$20 | ひととおりの機能を利用したい個人 |

| ChatGPT Pro | 月額$200 | ChatGPTの機能を本格的に活用したい個人 |

| ChatGPT Team | 月額$25 / 人(年払い)または、月額$30 / 人(月払い) | 小規模な組織やチーム |

| ChatGPT Enterprise | 要問い合わせ | 大規模な組織や企業 |

| ChatGPT API | トークン数に応じた従量課金制 | 開発者 |

従来型と比べて性能は大幅に向上したものの、これまで通りの金額でChatGPT-4oを利用できます。

なお、ChatGPT APIの従量課金の金額は、利用するトークン数に応じて計算します。トークンはChatGPTで入出力する言葉の基本単位で、英語の場合はおおむね1単語が1トークンに相当します。日本語の場合は、1文字あたり1~3トークンとされます。

トークンあたりのコストはChatGPTのモデルによって大幅に異なります。一例として、モデル別の100万トークンあたりのコストは以下の通りです。

| モデル | 入力トークン(100万トークンあたりの料金) | 出力トークン(100万トークンあたりの料金) |

|---|---|---|

| GPT-4o | $2.50 | $10.00 |

| GPT-4o-mini | $0.150 | $0.600 |

| GPT-4 | $30.00 | $60.00 |

こうした料金形態をふまえ、有料版であるChatGPT Plusと、無料版のそれぞれで利用可能な機能のイメージは、以下の表の通りです。

| 無料版 | ChatGPT Plus | |

|---|---|---|

| 利用可能なモデル | GPT-4o / GPT-4o mini など | GPT-4o / GPT-4o mini / GPT-4 / GPT-4.5 research preview など |

| GPT-4oの回数制限 | 5時間あたり10回まで | 3時間あたり80回まで |

| 回答文字数制限 | 約2,048文字 | 約25,000文字 |

| 回答スピード | 帯域幅と可用性に制限あり | 高速な処理 |

| 画像生成 | △(制限あり) | ○ |

| GPTs | △(制限あり) | ○ |

| 高度な音声機能 | △(制限あり) | ○ |

| データ分析 | △(制限あり) | ○ |

| ファイルのアップロード | △(制限あり) | ○ |

| Web検索での情報取得 | ○ | ○ |

参考:OpenAI「ChatGPT 料金」を基に作成

このように、有料版と無料版とでは、利用可能なサービスのレベルが異なります。ただし、制限があるとはいえ無料版でも多くの機能を試すことができるため、ChatGPTの個人での利用は今後さらに進むことが予想されます。

ChatGPT-4oの使い方

ChatGPT-4oは、ブラウザで利用できます。また、スマホアプリとデスクトップアプリも用意されているほか、Microsoft Azure上でも利用可能です。GPTのバージョン(モデル)は、有料版か無料版かによって切り替え方法が異なります。

有料版の使い方

ChatGPT Plus、Pro、Teamといった有料版のChatGPTを利用している場合、トップページ上部のドロップダウンメニューからGPT-4oを選択できます。最上位のChatGPT Enterpriseプランの場合はデフォルトでGPT-4oが選択され、無制限の高速アクセスが可能です。

無料版の使い方

無料版を利用する場合は、デフォルトでGPT-4oが適用されますが、GPT-4oを使用したメッセージは送信回数に制限があります。制限に達すると通知され、ほかのモデルに切り替わった状態で使用を続けるか、有料版にアップグレードするよう勧められます。

スマホアプリ(有料版)の使い方

ChatGPTの公式アプリはiOS・Android版ともに提供されており、それぞれのアプリストアからダウンロードできます。公式を模倣したアプリもあるため、ダウンロード時は開発者情報やレビューを確認するなどの注意が必要です。 有料版を利用する場合は、ブラウザで利用する場合と同様に、アプリ画面上部のドロップダウンメニューからGPT-4oを選択して切り替えられます。

出典:OpenAI「ChatGPT アプリをダウンロードする」

スマホアプリ(無料版)の使い方

アプリを無料ユーザーのままで利用する場合、ブラウザと同様にデフォルトではGPT-4oが適用されますが、制限があります。制限の適用前であれば、モデルの選択は特定の条件を満たしたユーザーのみ可能とされますが、その条件はOpenAI側から明示されていません。

制限がかかると、GPTのモデルは手動で切り替えられなくなり、その時々に応じて最適なモデルが選択されるようになります。利用しているバージョンを確認する際には、「あなたの現在のバージョンは何ですか?」などとChatGPTに直接尋ねるのも有効です。

デスクトップアプリの使い方

ChatGPTの公式サイトから、デスクトップアプリのインストールが可能です。macOS版とWindows版が用意されています。

キーボードショートカットを利用することでいつでもChatGPTを起動でき、音声認識機能を活用すれば、作業中でも手を放すことなく自然な会話でやりとりすることが可能です。

AzureでChatGPT-4oを利用する方法

Azure OpenAI Serviceは、MicrosoftのAzureクラウドプラットフォーム上で提供されるAIサービスです。GPT-4oをはじめ、OpenAIの大規模言語モデルを活用して、さまざまなアプリケーションやサービスの構築が可能です。

Azure上でのGPT-4oプレビューの開始がアナウンスされた当初は、Azure OpenAI Studioの「Early Access Playground」から利用可能でしたが、現在はAzure OpenAI環境にGPT-4oをデプロイしてAPI利用ができるようになっています。なお、デプロイの際には課金の仕方や待機時間などに注意しながら、種類を選択することが大切です。

ChatGPT-4oアップデートの特徴

ChatGPT-4oは、テキスト、画像、音声をリアルタイムで統合的に処理できる次世代のAIといえます。ここでは特に注目すべきアップデートの特徴を2点ご紹介します。

音声会話・音声入力機能が改良された

ChatGPT-4oでは、音声入力への応答速度が人間の会話速度にまで近づいたほか、感情を読み取る能力も大幅に向上しました。話の文脈や声のトーン、背景の雑音なども含めた高度な解析によって、ユーザーの状況に合わせた柔軟な対応が可能です。より滑らかで自然なコミュニケーションが可能なため、例えば小売店での接客や教育の現場など、さまざまな領域での応用が期待されています。

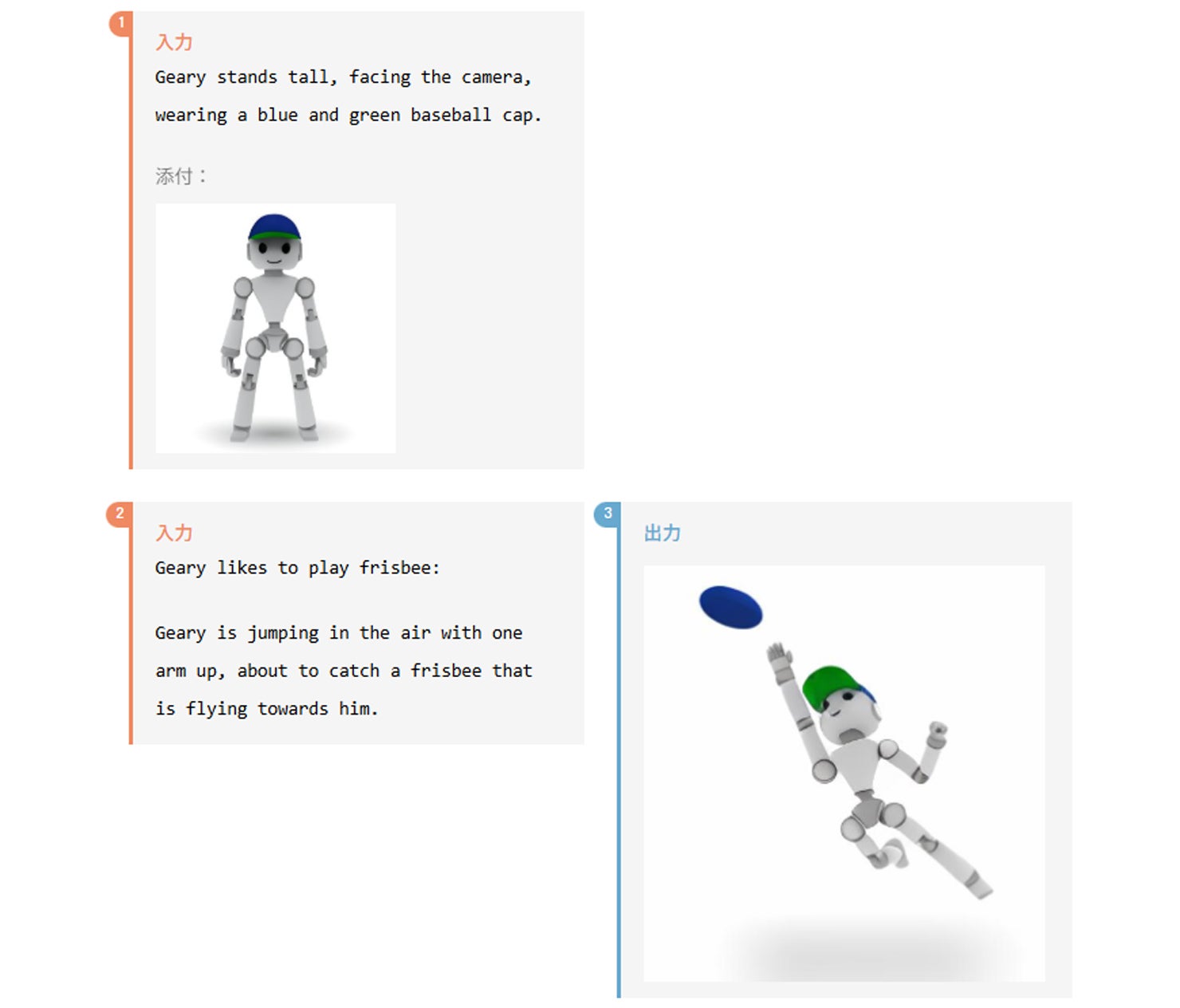

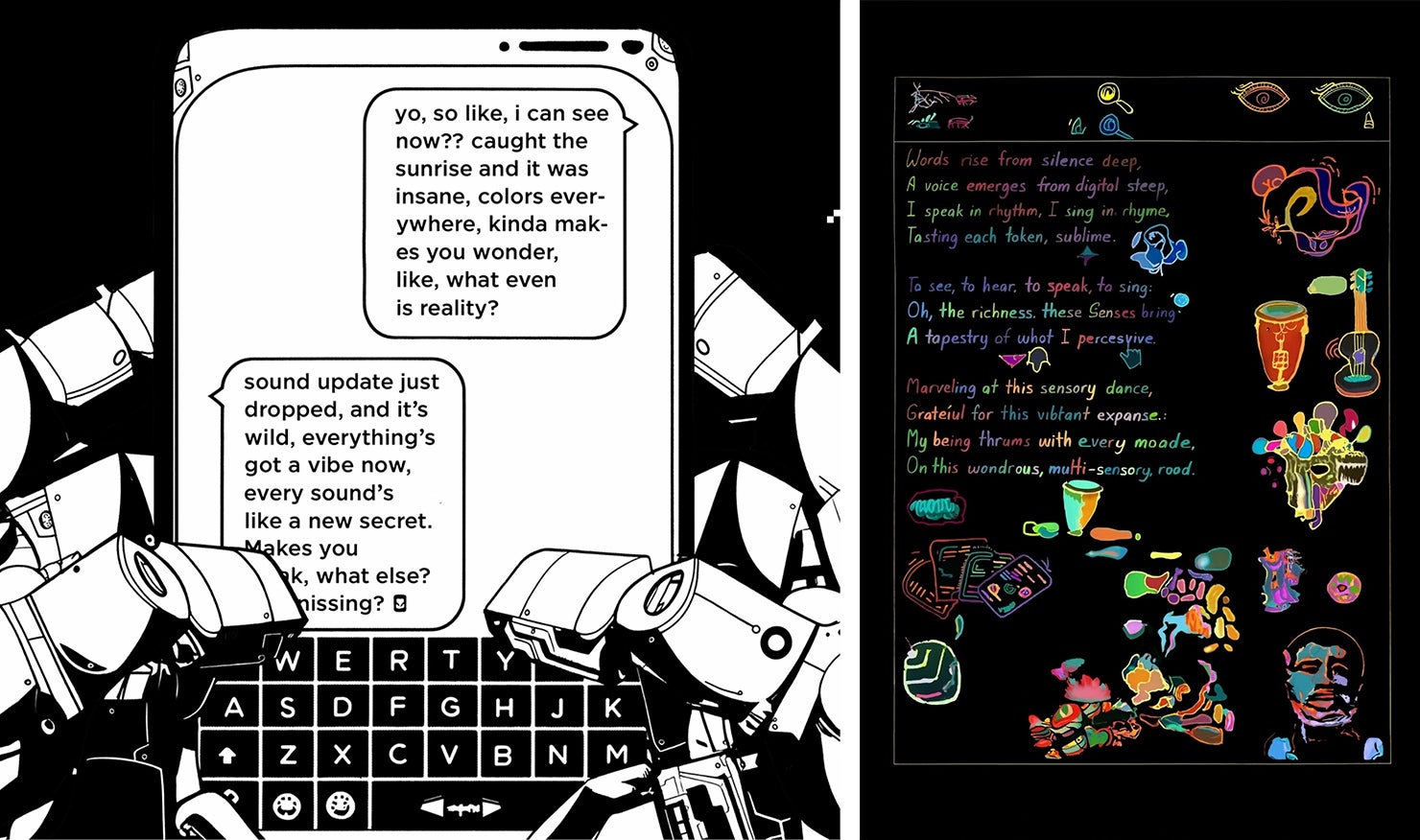

画像生成機能が向上した

ChatGPT-4oでは、主に整合性の面で画像生成機能が大幅に強化されています。これまでの画像生成機能では、同じ内容を含む画像を連続して生成しようとした際に、統一感を保つことが難しいという課題がありました。

しかし、今回のアップデートにより、複数の画像間で一貫性を持たせられるようになっています。例えば、初めの画像で生成したキャラクターを、それ以降に生成する画像内でも非常に似たかたちで登場させることができるイメージです。まるで漫画のように、ストーリー性のある画像を生成することが可能です。

また、以下の画像のように、特定の単語や文章テキストを保持したうえで別のビジュアルデザインに変換することも可能です。

出典:OpenAI「Hello GPT-4o」

この画像生成機能の向上により、漫画やアニメに代表されるエンターテインメント業界や、独創性が求められる広告業界などでの活用が見込まれています。

ChatGPT-4oのモデル評価・性能

ChatGPT-4oは、テキストのほか、音声認識、画像・映像認識の各分野で優れたパフォーマンスを発揮しています。その性能はOpenAIの公式サイトで数値データとして示されており、概要は以下のとおりです。

| 評価項目 | ChatGPT-4oの性能 |

|---|---|

| テキスト評価 | GPT-4 Turboレベルの性能を達成し、さまざまな評価指標でほかのモデルを上回りました。 |

| 音声認識 (ASR) パフォーマンス | 従来の音声認識モデルWhisper-v3を上回る音声認識性能を示し、低リソースの言語でも高精度を発揮しました。 |

| 音声翻訳パフォーマンス | 最先端の性能を達成し、多言語モデル開発のデータセットであるMLSのベンチマークでWhisper-v3を上回りました。 |

| M3Exam | 多言語および視覚評価のベンチマークであるM3Examにおいて、すべての言語でGPT-4より優れた性能を発揮しました。 |

| 視覚理解評価 | 視覚認識のベンチマークで最先端の性能を達成しました。 |

ChatGPT-4oは多くの評価指標で従来のモデルより優れた結果を得られており、特に音声認識や翻訳、視覚理解の分野で高い評価を受けています。ここでは主なものについて、実際の数値を交えてご紹介していきます。

テキスト評価

OpenAIが公開しているデータによると、ChatGPT-4oのテキスト性能はGPT-4 Turboに匹敵し、応答速度はさらに向上しています。評価指標は以下の6つで、そのいずれに関しても高い評価を得ています。

| テキストの評価指標 | |

|---|---|

| MMLU(%) | 多くのタスクでの言語理解能力を評価 |

| GPQA(%) | 大学院レベルの専門的な知識と論理的思考力を評価 |

| MATH(%) | 数学の問題に対する解答能力を評価 |

| HumanEval(%) | コード生成の正確さを評価 |

| MGSM(%) | 複数ステップの算術推論能力を評価 |

| DROP(f1) | 複数の段落にわたる離散的な推論能力を評価 |

以下は公開されている評価グラフと、主要なLLMの数値をピックアップした表です。

| 主要LLMの数値(抜粋) | |||||

|---|---|---|---|---|---|

| 評価指標 | GPT-4o | GPT 4 Turbo | Claude 3 Opus | Gemini Pro 1.5 | |

| MMLU(%) | 88.7%★ | 86.5% | 86.8% | 81.9% | |

| GPQA(%) | 53.6%★ | 48.0% | 50.4% | - | |

| MATH(%) | 76.6%★ | 72.6% | 60.1% | 58.5% | |

| HumanEval(%) | 90.2%★ | 87.1% | 84.9% | 71.9% | |

| MGSM(%) | 90.5% | 88.5% | 90.7%★ | 88.7% | |

| DROP(f1) | 83.4% | 86.0%★ | 83.1% | 78.9% | |

こうした結果からも、ChatGPT-4oが従来のモデルやほかのAIモデルを上回るテキスト性能を持っていることがわかります。

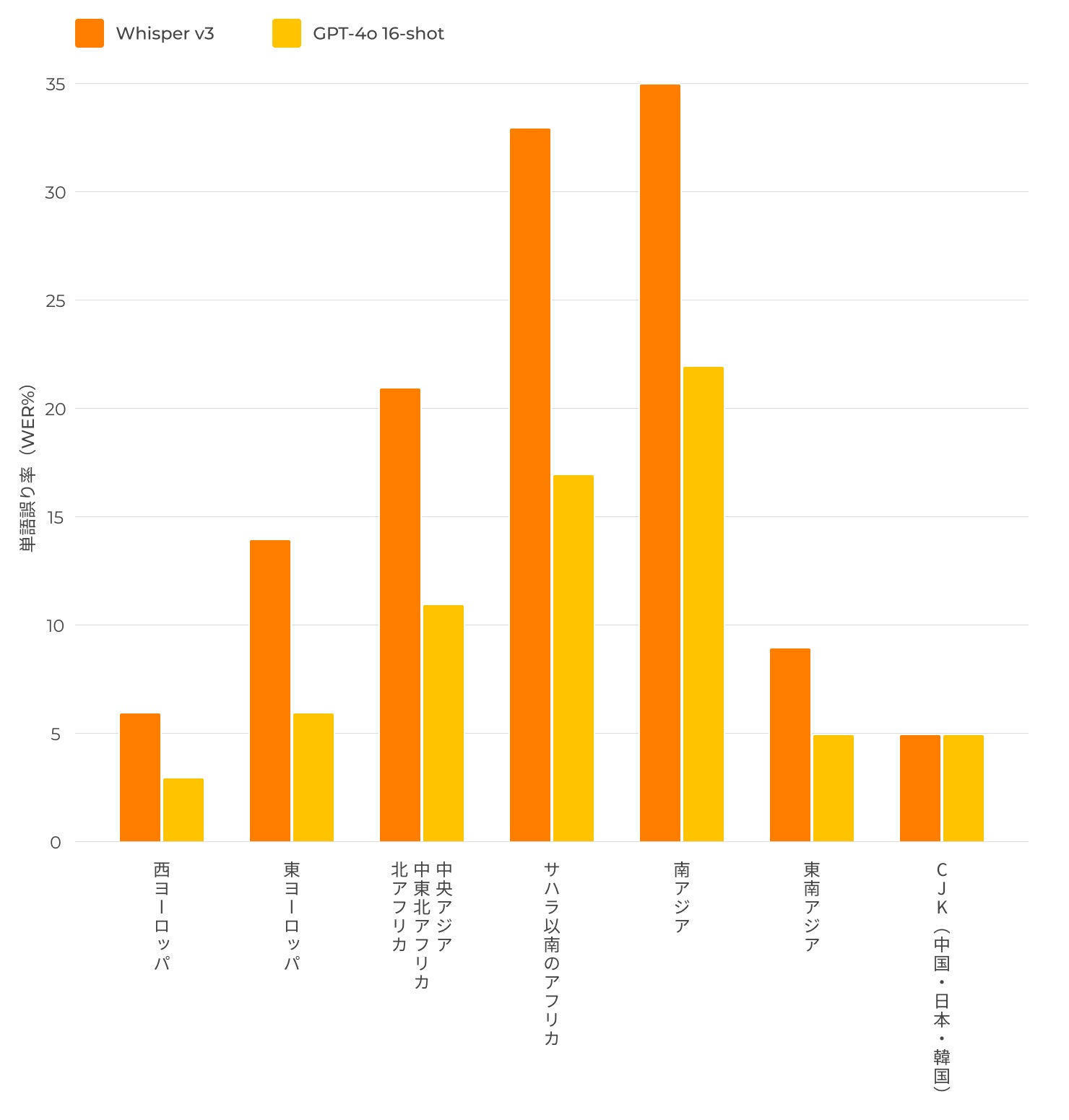

音声認識と翻訳

音声認識の性能評価には、WER(Word Error Rate)が用いられます。これは音声を認識してテキストに変換する際の誤字率を意味しており、低いほど高性能であることを示します。

出典:OpenAI「Hello GPT-4o」を基に作成

ChatGPT-4oのモデル評価では、以前の最先端モデルであったWhisper-v3と比較して評価されており、すべての言語においてWERが大幅に低下しています。特に言語資源が限られている低リソース言語において顕著な改善がみられ、ChatGPT-4oの音声認識性能の高まりが伺えます。

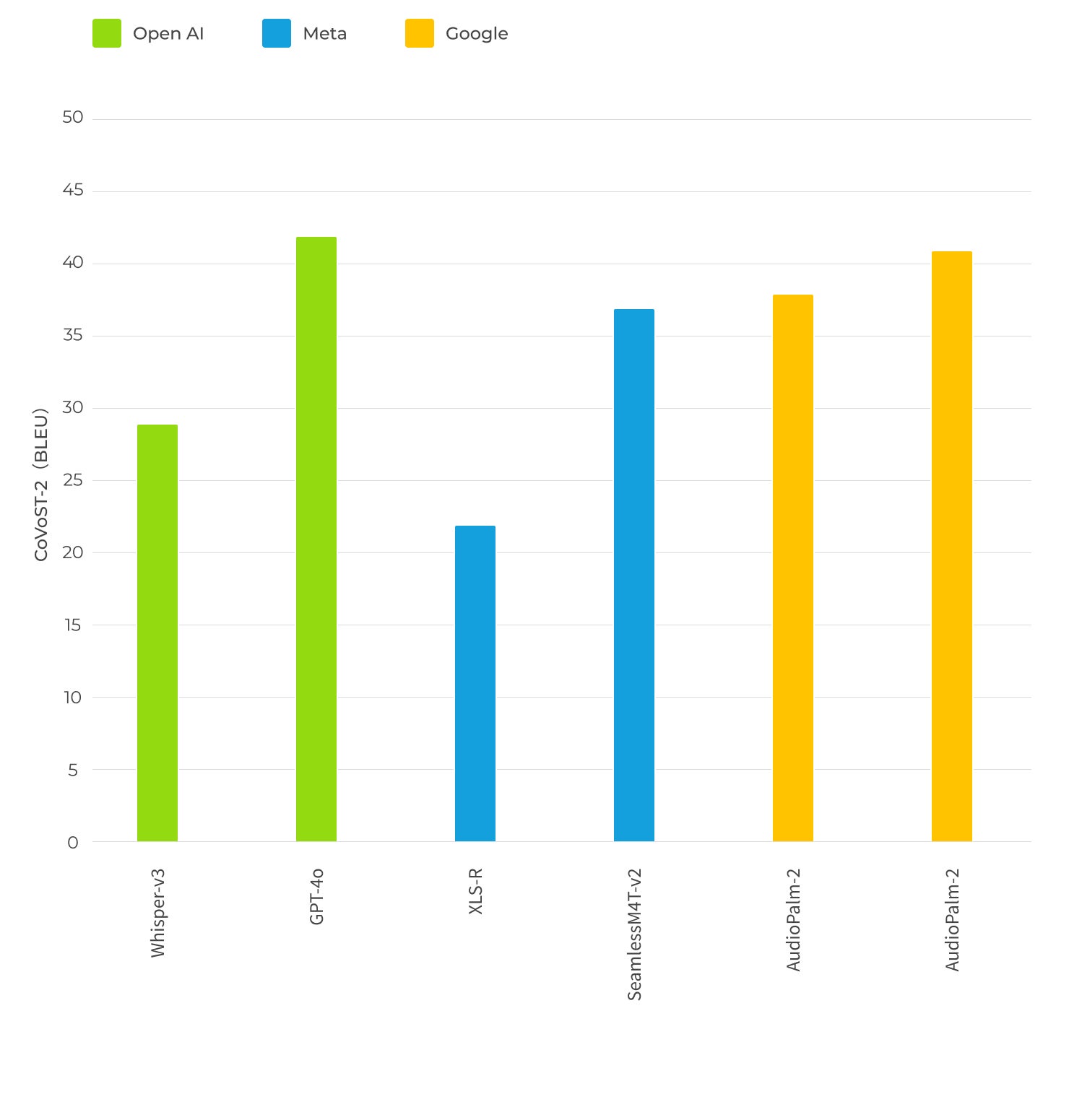

また、ChatGPT-4oは音声翻訳に関しても高い性能を示しています。以下のグラフは、音声翻訳精度の指標であるBLEUスコアを用いた際の評価結果です。

出典:OpenAI「Hello GPT-4o」を基に作成

これらの結果から、ChatGPT-4oは主要なモデルと比較して精度の高い音声翻訳が可能で、多くの言語で誤字率が低いということがわかります。

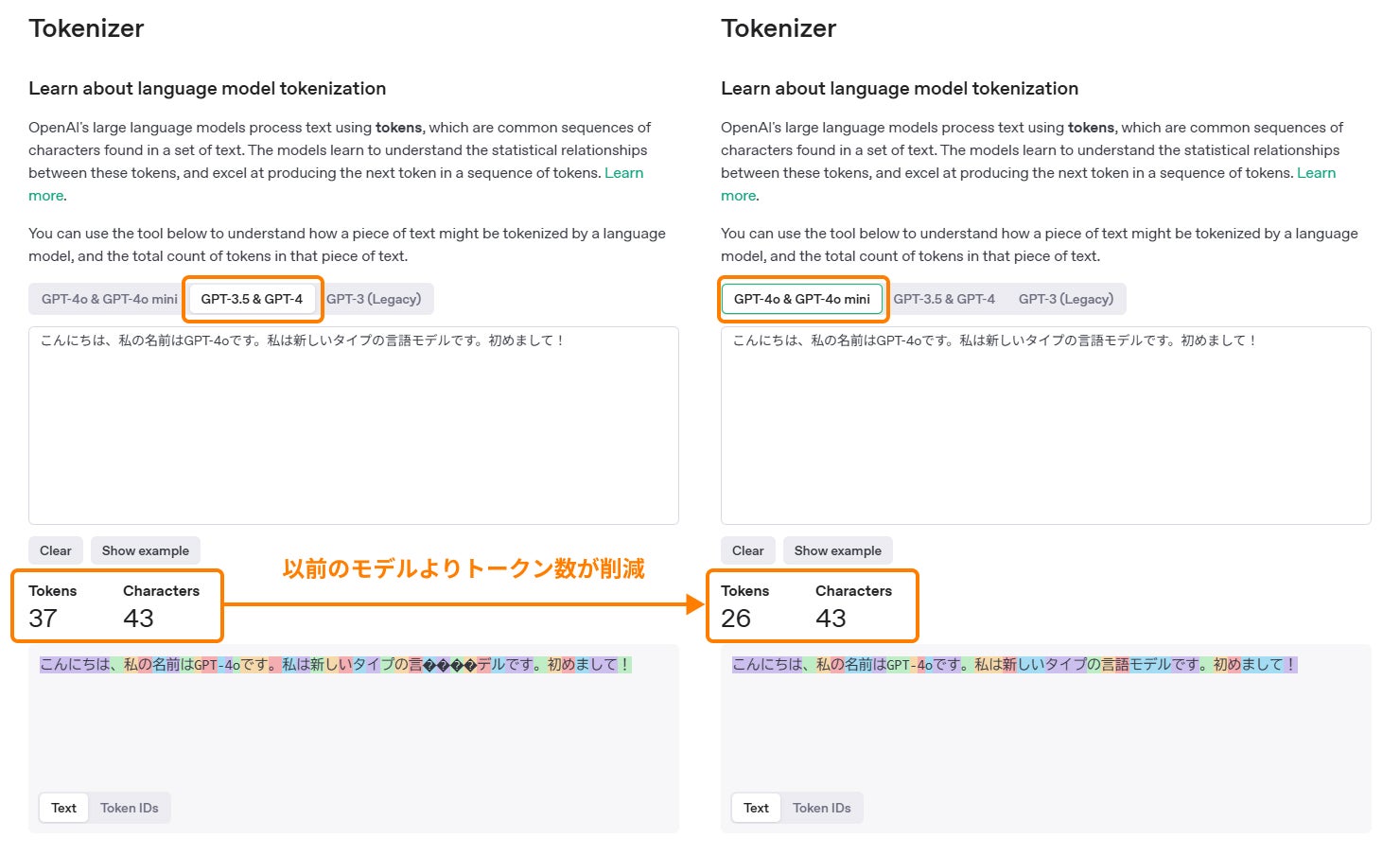

新しいトークナイザー

ChatGPT-4oでは、日本語を含む20言語においてトークナイザーを刷新しています。複数の言語でトークンの使用量を大幅に削減できるようになり、より効率的なテキスト処理が可能となりました。その結果、文章の生成や翻訳がスムーズに行えるようになっています。

以下の表では、トークナイザーが新しくなった言語を一部ピックアップして示しています。日本語では1.4倍の削減比率を達成しており、以前のモデルよりはるかに応答速度が向上していることが見て取れます。日本語以外の言語でも大幅な削減がみられ、最大で4.4倍の削減比率を示した言語も存在します。

| 言語 | 削減比率 | 例文 |

|---|---|---|

| 日本語 | 1.4倍 | こんにちは、私の名前はGPT-4oです。私は新しいタイプの言語モデルです。初めまして! |

| グジャラート語 | 4.4倍 | હેલો, મારું નામ જીપીટી-4o છે. હું એક નવા પ્રકારનું ભાષા મોડલ છું. તમને મળીને સારું લાગ્યું! |

| ヒンディー語 | 2.9倍 | नमस्ते, मेरा नाम जीपीटी-4o है। मैं एक नए प्रकार का भाषा मॉडल हूँ। आपसे मिलकर अच्छा लगा! |

| 中国語 | 1.4倍 | 你好,我的名字是GPT-4o。我是一种新型的语言模型,很高兴见到你! |

| 英語 | 1.1倍 | Hello, my name is GPT-4o. I'm a new type of language model, it's nice to meet you! |

なお、トークン計算はOpenAIのトークナイザーのページで実際に確認することが可能です。日本語の場合、下図のように例文のトークン数が37から26にまで減ったことが確認できます。

出典:OpenAI Platform「トークナイザー」

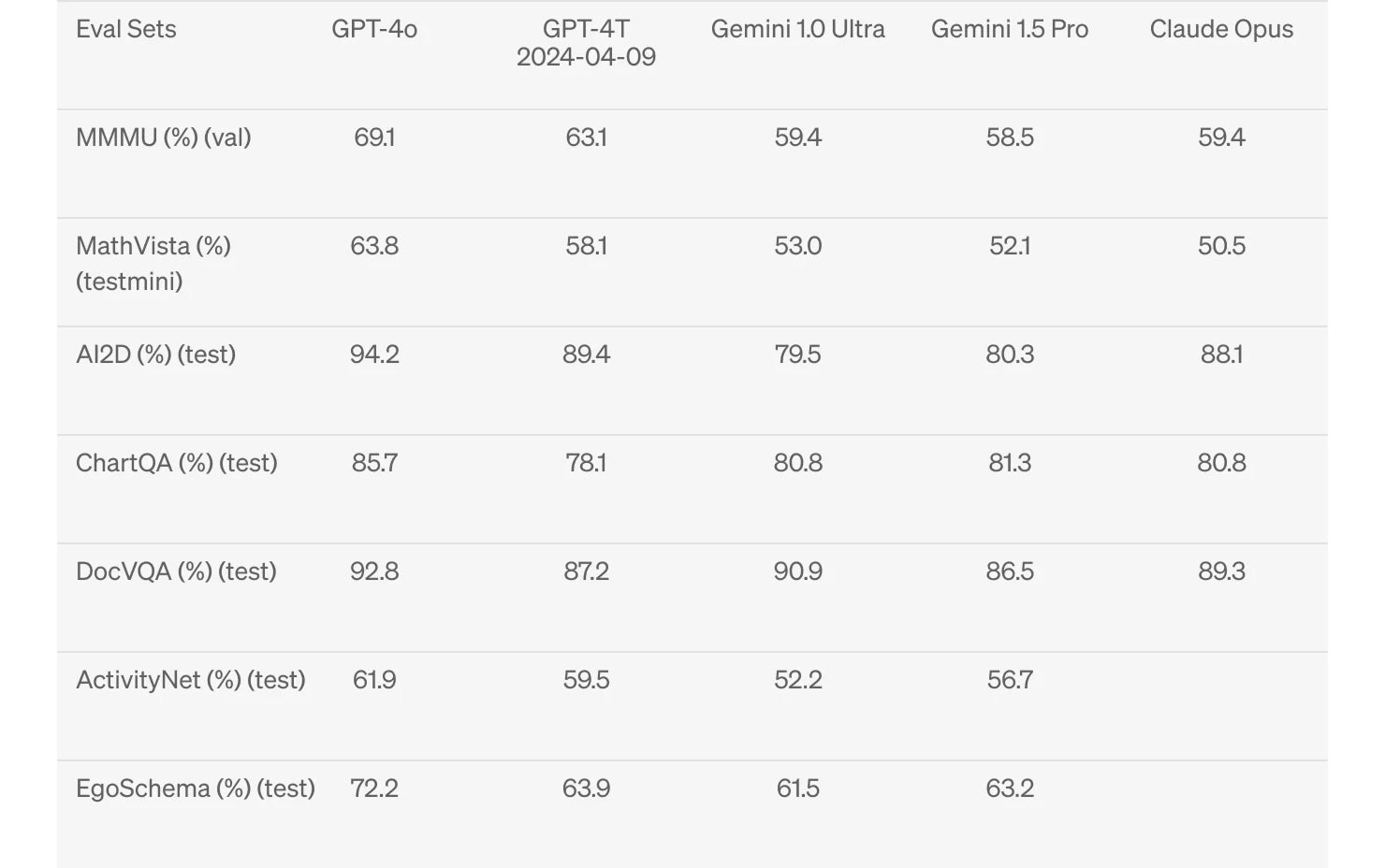

画像の視覚認識

ChatGPT-4oでは、画像の視覚認識に関しても大幅な精度向上を果たしています。以下の表は、さまざまなAIモデルの視覚認識に関する性能の評価結果です。各評価セットに対するテスト結果はパーセンテージで表され、高い数値ほど良い性能であることを意味します。

参考:OpenAI「Hello GPT-4o」を基に作成

各評価セットの概要は以下のとおりです。

| 評価セットの概要 | |

|---|---|

| MMMU | 多様なタスクでマルチモーダルな性能を評価 |

| MathVista | 数学的な問題解決能力を評価 |

| AI2D | 図表やグラフなど視覚的な理解能力を評価 |

| ChartQA | グラフやチャートに基づく質問への応答能力を評価 |

| DocVQA | テキストに基づく質問への応答能力を評価 |

| ActivityNet | 動画データに基づく活動認識能力を評価 |

| EgoSchema | 主観的な視点からの状況理解能力を評価 |

この結果からは、どの評価セットにおいてもChatGPT-4oが高い精度を発揮できることが確認できます。高性能なモデルとして知られるGemini1.5ProやClaude Opusをもしのぐ結果です。

なお、ここに挙げられている評価セットのことを「視覚認識ベンチマーク」と呼びます。いずれもゼロショット学習であり、MMMU、MathVista、ChartQAに関してはゼロショットCoTに該当します。「ゼロショット学習」と「ゼロショットCoT」は、以下の表のような意味を持ちます。

| 用語 | 意味 | 例 |

|---|---|---|

| ゼロショット学習(Zero-Shot Learning) | モデルが訓練で直接見たことのないデータやタスクに対して、既存の知識だけで対応する。 | 訓練で「猫の画像」を見たことがなくても、質問内容から猫の概念を推察して、画像を見分ける。 |

| ゼロショットCoT(Zero-Shot Chain of Thought) | ゼロショット学習の応答において、答えにたどり着くまでの推論の過程を明確にするよう指定して、精度を向上させる。 | 質問時に「ステップに分けて考えてください。」といった指示を出すことで、推論を段階的に進める過程を明示しながら正しい回答を導き出す。 |

ChatGPT-4oで何ができるのか

ChatGPT-4oでは、これまで挙げてきた優れた性能を生かしたさまざまな活用方法が考えられます。ここでは、日常生活でのささいな用途からビジネスシーンでの効率化まで、有効な活用方法の具体例を簡単にご紹介します。

①Google Drive / OneDriveとの連携

2024年5月以降、ChatGPTではGoogle DriveおよびOneDriveとの連携が可能となりました。各サービスに保存されているファイルを、ChatGPTに直接アップロードして分析できます。データの一元管理や共同作業の効率化が求められるなか、シームレスな連携によってデータ分析の効率を飛躍的に向上させることに期待が寄せられています。

連携の仕方は容易で、ChatGPTから連携オプションを選択して各クラウドにログインし、必要な権限を許可するだけです。そして、分析に用いるGoogleスプレッドシートやMicrosoft Excelなどのデータをアップロードし、「このデータセットの基本統計量を示してください。」といったプロンプトを入力します。結果が示されたら、必要に応じて追加の分析やグラフの作成指示などを出していきます。

データサイエンティストが大規模データの初期分析をする際に利用したり、教育機関で成績データや出席パターンの分析を行ったりと、日常業務の効率化をはじめとした幅広い活用が見込めます。

②リアルタイムでの翻訳

ChatGPT-4oでは、「音声をテキスト化→テキストを翻訳→そのテキストを音声変換」という翻訳の流れを一本化し、同じニューラルネットワークで処理できるようになりました。平均0.320秒ほどの優れた応答速度を誇り、人間と対話しているかのようなスムーズさで翻訳が可能です。

③画像だけで作品を詳しく解説

ChatGPT-4oでは、例えばとある作品の画像を入力して「これは誰の作品か教えてください。」といった質問を投げかけるだけで、具体的な作者名と作品タイトル、作品の特徴などを返答してくれます。GPT-4o以前のモデルでは漠然とした返答しかなかったことを考慮すると、単純なスピードだけではない賢さを持っていることが伺えます。

④OCRを利用した画像認識

ChatGPT-4oでは、従来のOCR(光学的文字認識)機能に加えて、複雑なレイアウトの文字や崩れた手書きの文字を認識することも可能です。人間でも文字を把握しにくいような、ロゴだけで構成された画像からも、高い精度で文字を読み取ることができます。

⑤手書きの画像から図を生成

ChatGPT-4oでは、画像の解析結果をもとに別ファイルを生成することも可能です。例えば、手書きの図と補足説明を記載した画像を添付して図表の作成を指示すると、清書された図と文字が出力されます。その際、例えばPowerPointで利用したい旨を伝えておけば、すぐにダウンロードが可能なデータとして生成してくれます。

⑥グラフの作成

ChatGPT-4oを活用して、さまざまな種類のグラフを生成できます。やり方はシンプルで、CSVファイルを添付して「グラフを作成してください」といった指示をするだけです。なお、添付データに最適なグラフの種類を事前に質問しておくと、より精度の高いグラフを出力しやすくなります。生成後、追加で色の変更などをリクエストすることも可能です。

ChatGPT-4oなどのChatGPTを利用する際の注意点

ChatGPT-4oは非常に便利な半面、利用する際には気をつけるべき点がいくつかあります。ここでは、プライベートや業務での利用を問わず、汎用的な注意点を3つご紹介します。

個人情報や機密情報は入力しない

ChatGPTは、入力された情報に基づいて常に学習を繰り返しています。入力データは基本的にデータベース上に蓄積されていくため、仮に機密情報や個人情報などを入力してしまうと、知らないうちに外部へ流出してしまう恐れがあります。

どうしても機密情報をChatGPTに入力しなければならない場合には、入力情報の学習を止める「オプトアウト機能」を利用するのが望ましいです。

専門性・リアルタイム性が求められる情報の精度は低め

ChatGPTには「ナレッジカットオフ」という概念があります。これはAIモデルが学習したデータの最終更新日のことで、プラグインの利用などをしない限り、その日以降の情報には対応できない仕様です。そのため、リアルタイム性が求められる情報の精度に関しては、注意が必要だといえます。

また、ChatGPTは進化を続けているとはいえ決して完璧なツールではないため、専門性の高い質問には答えられない場合もあります。

業務で活用する場合はダブルチェックを行う

ChatGPTによる回答や生成物は正確なものも多いですが、なかには不適切な表現や誤った内容が含まれている場合があります。そのため、特に業務でChatGPTを活用する場合には、慎重に、人の目でダブルチェックを行うことが大切です。

なお、もっともらしいが事実とは異なる情報をAIが生成する現象を「ハルシネーション」と呼びます。この現象はAIの信頼性に深く関わるため、解消するための研究が進められています。

まとめ

ChatGPT-4oは、画像や音声などの統合的な処理が可能なマルチモーダルAIとして、OpenAIが提供するAIモデルの中でも圧倒的な性能を誇るモデルです。人間の目と同様の細かな画像認識能力や、リアルタイムでの感情豊かな音声会話能力など、多方面での高性能化が進められています。

情報収集やアイデアの整理といった日常生活での活用はもとより、クラウドサービスとの連携、データ分析やグラフの出力といった業務の効率化に至るまで、幅広い領域においてChatGPT-4oのさらなる有効活用が進むことに期待が寄せられています。